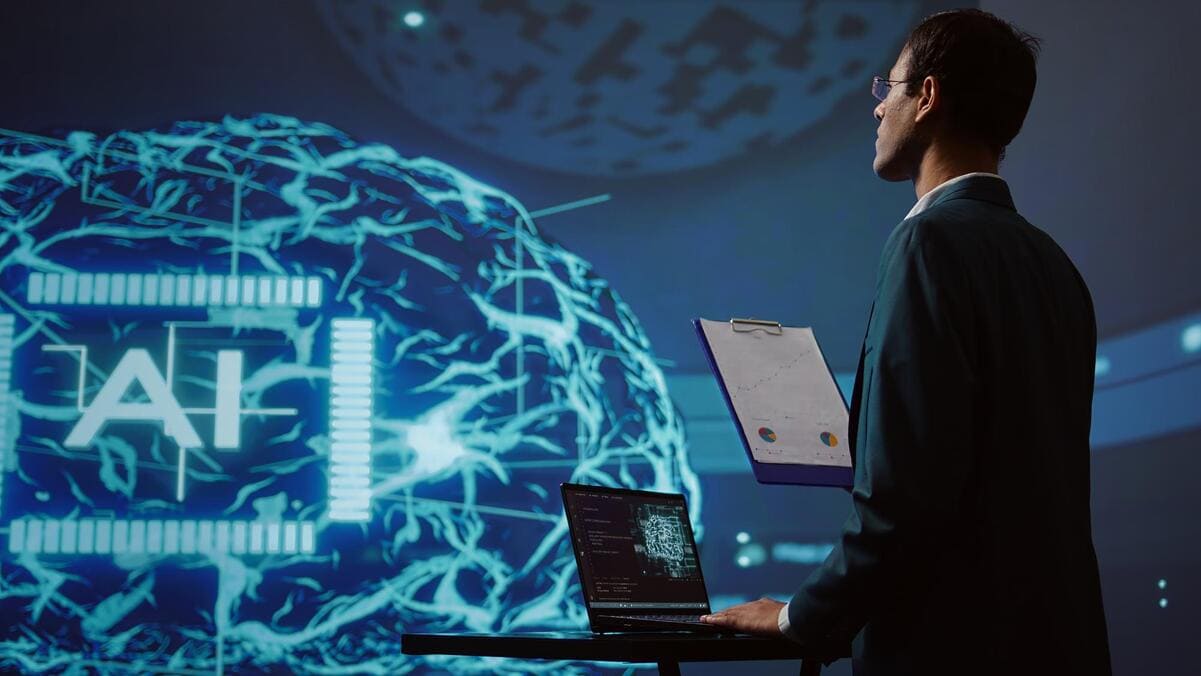

En agosto de 2024, entró en vigor el Reglamento (UE) 2024/1689 de Inteligencia Artificial (RIA o RAI, por sus siglas en inglés). El objetivo principal de este acuerdo es fomentar el desarrollo y la implantación responsable de la IA en toda la Unión Europea.

Actualmente, más del 24% de las empresas españolas ya utilizan alguna herramienta de Inteligencia Artificial; hablamos de 1 de cada 4 compañías, según el “III Informe sobre Transformación digital” de InfoJobs.

Es importante tener cautela ante el uso de herramientas de inteligencia artificial. A nivel empresarial tenemos que ser conscientes de que el despliegue de estas aplicaciones requiere realizar un análisis previo e implantar las medidas de seguridad adecuadas, ya que hay que tener en cuenta que la IA conlleva importantes ventajas, pero también riesgos considerables.

El RIA determina varias categorías de operadores: proveedores, representantes, distribuidores, importadores, proveedores posteriores y responsables de despliegue. A priori, los proveedores de sistemas IA de alto riesgo son los que habrán de asumir un conjunto más complejo de obligaciones. Esto se debe a que son más susceptibles de causar daños para la salud, la seguridad o los derechos fundamentales de las personas. Se trata de sistemas IA que están destinados a utilizarse como componentes de seguridad -o que son sistemas de seguridad por sí mismos- en vehículos a motor, productos sanitarios, juguetes, motos acuáticas, ascensores, etc.), así como a otros usos de IA vinculados con los llamados “sistemas independientes” (infraestructuras críticas, sistemas de identificación biométrica remota, sistemas utilizados en el ámbito educativo y de formación profesional, o sistemas utilizados en el ámbito de la selección de personal y laboral, entre otros).

La aplicación del RIA será progresiva. El primer hito viene marcado por la aplicación de las prohibiciones de uso, en fecha 2 de febrero de 2025. Las organizaciones afectadas deben tener en cuenta que, si no se adaptan a la normativa en los plazos previstos, podrían ser gravemente sancionadas con multas que, en los casos más graves, pueden alcanzar los 35 millones de euros o el 7% del volumen de negocio total del ejercicio anterior, lo que suponga mayor cuantía.

Para aplicar correctamente el RAI, resulta imprescindible saber distinguir entre qué es la IA y qué no lo es, teniendo en cuenta además que el concepto “Inteligencia Artificial” se está utilizando, en algunos casos, como una estrategia de marketing. En este sentido, no cabe duda de que hacer referencia a la IA como supuesto componente de un producto o servicio despierta cierta fascinación que hace más atractiva la comercialización, aunque verdaderamente no incorporen IA. Este uso indiscriminado puede dar lugar a una aplicación incorrecta del RAI, generando así confusión a la hora de determinar qué requisitos y obligaciones legales resultan verdaderamente exigibles en cada caso.

Juan Manuel Valiente, responsable del Área Jurídica de Secure&IT, y Natalia Patiño, consultora Legal TIC de Secure&IT

En relación con el uso de herramientas de IA generativa en el ámbito laboral/profesional -como por ejemplo ChatGPT, Gemini, etc- es esencial establecer una política específica de uso y llevar a cabo acciones formativas dirigidas a los usuarios aprendan, por ejemplo, a introducir los “prompts” (entradas de información que realizan los usuarios) de una forma segura y eficaz; o a tomar conciencia de la importancia de la supervisión humana ante riesgos como la generación de resultados incorrectos o incluso inventados (“alucinaciones”).

Asimismo, no hay que olvidar que las herramientas IA también están expuestas a riesgos relacionados con incidentes de seguridad que pueden sufrir los proveedores de IAs generativas, y que podría comprometer la información sensible que se les proporciona en los “prompts”. Por otro lado, también existen riesgos relacionados con la protección de obras en materia de propiedad intelectual, debido a que no todas las creaciones realizadas a través de sistemas de IA contarán con protección.

Lo cierto es que la aprobación de este Reglamento comunitario, y de otras normativas como el Reglamento de Servicios Digitales (DSA), ya ha tenido las primeras reacciones: Apple ha comunicado que la integración de su IA, Apple Intelligence, no se producirá en Europa, por lo menos, a corto plazo. A lo largo del próximo año 2025, Apple Intelligence estará disponible en varios idiomas, entre los que se incluye el español, pero no estará operativa en la Unión Europea, debido a la política de Bruselas con respecto a la IA.

En este sentido, no se puede perder de vista que hoy en día la opacidad relativa a los conjuntos de datos usados para el entrenamiento de los grandes modelos de IA es imperante, tanto en OpenAI como en sus competidoras.